作为入门,这篇文章写得挺好的,在文章的后半部分,是hbase的shell的简单使用,我们可以通过shell来更好的了解一下hbase,实践出真知。

简介

HBase是一个分布式的、面向列的开源数据库,源于google的一篇论文《bigtable:一个结构化数据的分布式存储系统》。HBase是Google Bigtable的开源实现,它利用Hadoop HDFS作为其文件存储系统,利用Hadoop MapReduce来处理HBase中的海量数据,利用Zookeeper作为协同服务。

HBase的表结构

HBase以表的形式存储数据。表有行和列组成。列划分为若干个列族/列簇(column family)。

|

Row Key

|

column-family1

|

column-family2

|

column-family3

|

|

column1

|

column2

|

column1

|

column2

|

column3

|

column1

|

|

key1

|

t1:abc

t2:def

|

|

t4:lookfor404

t3:hello

t2:world

|

|

|

|

|

key2

|

t3:abc

t1:lipengfei

|

|

t4:java

t3:hello

|

|

t2:hadoop

t3:hbase

|

|

|

key3

|

|

t2:dfadfasd

t1:dfdasddsf

|

|

|

|

t2:hi

t1:fine

|

如上图所示,key1,key2,key3是三条记录的唯一的row key值,column-family1,column-family2,column-family3是三个列族,每个列族下又包括几列。比如column-family1这个列族下包括两列,名字是column1和column2,t1:abc,t2:def是由row key1和column-family1-column1唯一确定的一个单元cell。这个cell中有两个数据,abc和def。两个值的时间戳不一样,分别是t1,t2, hbase会返回最新时间的值给请求者。

这些名词的具体含义如下:

(1)Row Key

与nosql数据库们一样,row key是用来检索记录的主键。访问hbase table中的行,只有三种方式:

1.通过单个row key访问

2.通过row key的range

3.全表扫描

Row key行键 (Row key)可以是任意字符串(最大长度是 64KB,实际应用中长度一般为 10-100bytes),在hbase内部,row key保存为字节数组。

存储时,数据按照Row key的字典序(byte order)排序存储。设计key时,要充分排序存储这个特性,将经常一起读取的行存储放到一起。(位置相关性)

注意:

字典序对int排序的结果是1,10,100,11,12,13,14,15,16,17,18,19,2,20,21,…,9,91,92,93,94,95,96,97,98,99。要保持整形的自然序,行键必须用0作左填充。

行的一次读写是原子操作 (不论一次读写多少列)。这个设计决策能够使用户很容易的理解程序在对同一个行进行并发更新操作时的行为。

(2)列族 column family

hbase表中的每个列,都归属与某个列族。列族是表的chema的一部分(而列不是),必须在使用表之前定义。列名都以列族作为前缀。例如courses:history , courses:math 都属于 courses 这个列族。

访问控制、磁盘和内存的使用统计都是在列族层面进行的。实际应用中,列族上的控制权限能帮助我们管理不同类型的应用:我们允许一些应用可以添加新的基本数据、一些应用可以读取基本数据并创建继承的列族、一些应用则只允许浏览数据(甚至可能因为隐私的原因不能浏览所有数据)。

(3) 单元 Cell

HBase中通过row和columns确定的为一个存贮单元称为cell。由{row key, column( =<family> + <label>), version} 唯一确定的单元。cell中的数据是没有类型的,全部是字节码形式存贮。

(4) 时间戳 timestamp

每个cell都保存着同一份数据的多个版本。版本通过时间戳来索引。时间戳的类型是 64位整型。时间戳可以由hbase(在数据写入时自动 )赋值,此时时间戳是精确到毫秒的当前系统时间。时间戳也可以由客户显式赋值。如果应用程序要避免数据版本冲突,就必须自己生成具有唯一性的时间戳。每个cell中,不同版本的数据按照时间倒序排序,即最新的数据排在最前面。

为了避免数据存在过多版本造成的的管理 (包括存贮和索引)负担,hbase提供了两种数据版本回收方式。一是保存数据的最后n个版本,二是保存最近一段时间内的版本(比如最近七天)。用户可以针对每个列族进行设置。

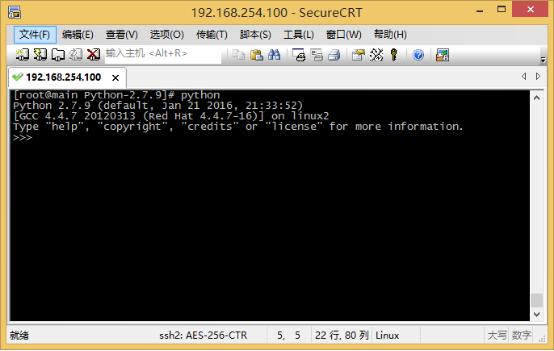

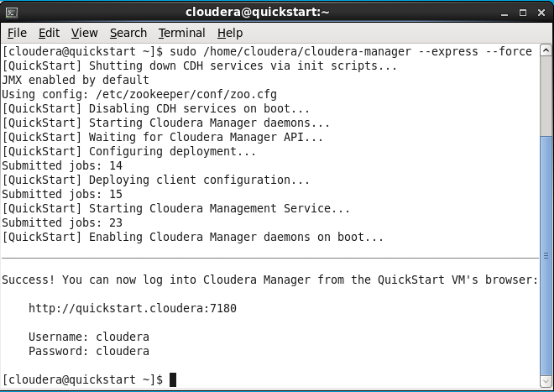

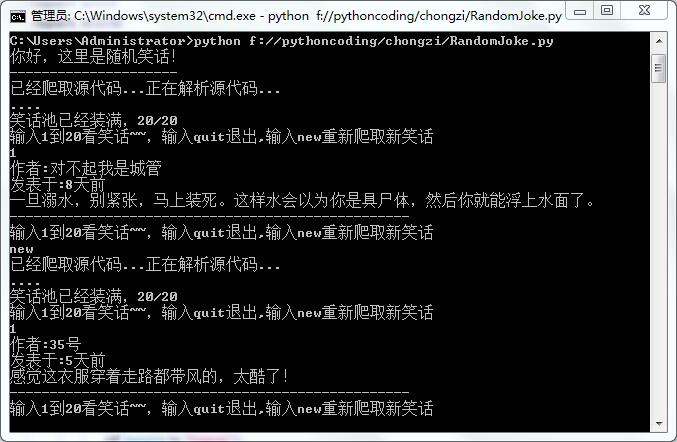

HBase shell的基本用法

hbase提供了一个shell的终端给用户交互。通过执行 help get 可以看到命令的帮助信息。进入shell很简单,切换目录到hbase的bin下,运行命令:

./hbase shell

以网上的一个学生成绩表的例子来演示hbase的用法。

|

name

|

grade

|

course

|

|

math

|

art

|

|

zkb

|

5

|

97

|

87

|

|

baoniu

|

4

|

89

|

80

|

这里grade对于表来说是一个列,course对于表来说是一个列族,这个列族由两个列组成math和art,当然我们可以根据我们的需要在course中建立更多的列族,如computer,physics等相应的列添加入course列族。图中需要注意的是90这个值,列族下面的列也是可以没有名字的。

(1) 建立一个表格scores 具有两个列族grade 和courese

键入命令:

create 'scores','grade', 'course'

(2) 查看当前HBase中具有哪些表

键入命令:

list

(3) 查看表的构造

键入命令:

describe 'scores'

(4) 加入一行数据,行名称为zkb 列族为grade,列名为””(空),值为5

键入命令:

put 'scores','zkb','grade:','5'

(5) 给zkb这一行的数据的列族course添加一列<math,97>

键入命令:

put 'scores','zkb','course:math','97'

(6) 给zkb这一行的数据的列族course添加一列<art,87>

键入命令:

put'scores','zkb','course:art','87'

(7) 加入一行数据,行名称为baoniu 列族为grade,列名为””(空), 值为4

键入命令:

put'scores','baoniu','grade:','4'

(8) 给baoniu这一行的数据的列族course添加一列<math,89>

键入命令:

put'scores','baoniu','course:math','89'

(9) 给Jerry这一行的数据的列族course添加一列<art,80>

键入命令:

put'scores','baoniu','course:art','80'

(10) 查看scores表中zkb的相关数据

键入命令:

get'scores','zkb'

(11) 查看scores表中所有数据

注意:scan命令可以指定startrow,stoprow来scan多个row,例如:scan 'user_test',{COLUMNS =>'info:username',LIMIT =>10, STARTROW => 'test',STOPROW=>'test2'}

键入命令:

scan'scores'

(12) 查看scores表中所有数据courses列族的所有数据

键入命令:

scan'scores',{COLUMNS => 'course'}

(13) 删除scores表

键入命令:

disable'scores'

drop'scores'

总结下,hbase shell常用的操作命令有create,describe,disable,drop,list,scan,put,get,delete,deleteall,count,status等,通过help可以看到详细的用法。

转自http://blog.csdn.net/smcwwh/article/details/7468672,有些许修改,感谢原作者!