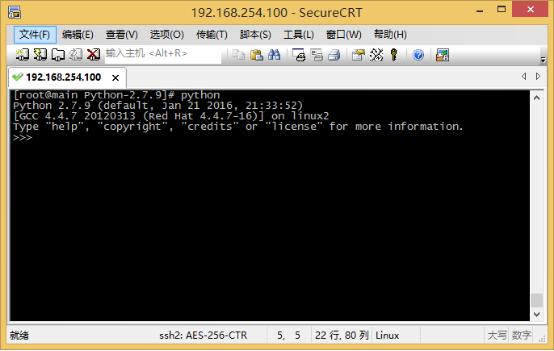

在Centos6.7中将python升级成2.7版本,网上有一大堆文章,但是要知道,没有永远正确的配置,每台机子,每个软件版本可能都不一样,所以要针对自己的问题,记录,找出对应的原因,才能以不变应万变啊。

不废话了,我这里记录一下在64位centos6.7中将python2.6.6升级为python2.7.12的过程。

1.安装devtoolset

devtoolset可以帮助我们解决gcc编译的问题,而在yum中,我们直接使用groupinstall,就能把工具组给安装了,很方便,输入以下命令:

yum groupinstall "Development tools"

2.安装编译Python需要的包:

yum install zlib-devel

yum install bzip2-devel

yum install openssl-devel

yum install ncurses-devel

yum install sqlite-devel

3.下载python2.7.12:

wget https://www.python.org/ftp/python/2.7.12/Python-2.7.12.tgz

4.解压:

tar -xvf Python-2.7.12.tgz

然后进入该目录:

cd Python-2.7.12

5.开始编译安装三部曲

./configure --prefix=/usr/local --enable-shared

make

make install

如果遇到错误:

error while loading shared libraries: libpython2.7.so.1.0: cannot open shared object file: No such file or directory

那就新建一个文件:

vim /etc/ld.so.conf.d/python2.7.conf

加入以下内容:

/usr/local/lib

保存退出后运行命令读取配置:

ldconfig

然后再重新编译安装三部曲即可。

看到网上很多教程有说,安装完新版本的python,系统还是用的默认的旧版本,所以需要更改软连接,还有yum的设置。但在我这里并没有遇到,我是可以直接用了,而且yum也正常。可能和python的版本有关,如果你在安装完之后出现,运行python,发现版本仍然是默认的版本,那么你就需要更改软连接了,更改完软连接之后,要检查yum是否正常。

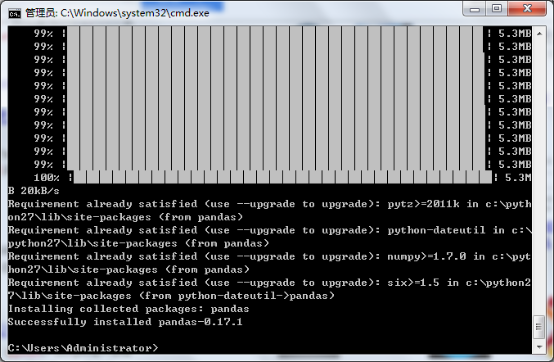

6.安装pip

在windows下,装完python2.7.12会默认把pip也装上。但在linux上有所不同,至少我在完成以上步骤之后,运行pip并没有反应。所以还需要安装pip。直接用yum神器:

yum install python-pip

7.安装python-devel

输入命令安装就行:

yum install python-devel

这就基本上就完成了python的升级。